18.09.2025 Sina Schäfer

ShareFoundation Models sind leistungsstarke KI-Modelle, die auf umfangreichen Datensätzen vortrainiert wurden und sich flexibel für unterschiedlichste Aufgaben und Anwendungsbereiche einsetzen lassen. Sie bilden das technologische Fundament vieler moderner KI-Systeme und ermöglichen es, spezialisierte Anwendungen darauf aufzubauen. Doch was zeichnet sie aus, wie funktionieren sie und welche Rolle spielen sie in der praktischen Nutzung? Dieser Beitrag gibt einen kompakten Überblick.

Definition: Was sind Foundation Models?

Foundation Models, im Deutschen auch als Basismodelle oder Grundmodelle bezeichnet, sind umfangreich vortrainierte KI-Modelle, die auf einer breiten Datenbasis aus Texten, Bildern oder anderen multimodalen Informationen basieren. Anders als spezialisierte KI-Modelle, die für eine einzelne, klar definierte Aufgabe trainiert werden, lernen Foundation Models aus einer Vielzahl von Daten und können ihr Wissen flexibel auf unterschiedliche Aufgaben übertragen. Je größer das Modell und je umfangreicher die Trainingsdaten, desto besser sind häufig auch die Leistungen in verschiedenen Aufgabenbereichen. Dabei nutzen sie moderne Architekturen wie den Transformer, um große Datenmengen effizient zu verarbeiten und Zusammenhänge über unterschiedliche Kontexte hinweg zu erfassen. Typische Anwendungen, die auf Foundation Models aufbauen, sind etwa Sprachassistenten, Bildgeneratoren oder KI-basierte Prognosewerkzeuge, also Systeme, die mit Hilfe des erlernten Wissens neue Aufgaben lösen können, ohne dass sie jedes Mal neu programmiert werden müssen.

Hintergrund und Kontext

Die Idee, ein zentrales Modell für viele unterschiedliche Aufgaben zu entwickeln, hat sich in den letzten Jahren zu einem der wichtigsten Trends in der KI-Forschung entwickelt. Erste Schritte in diese Richtung zeigten sich mit der Weiterentwicklung von Deep-Learning-Technologien ab etwa 2015. Insbesondere der Transformer-Ansatz, vorgestellt 2017, ermöglicht es, große Datenmengen effizient zu verarbeiten und dabei kontextuelle Zusammenhänge besser zu erfassen.

Auf dieser Grundlage entstanden erste Sprachmodelle, die nicht mehr nur einzelne Aufgaben erledigen, sondern sich durch Fine-Tuning für verschiedenste Zwecke adaptieren lassen. Der Begriff „Foundation Model“ wurde schließlich 2021 durch ein Forschungspapier der Stanford University geprägt, die diese neue Klasse von Modellen systematisch beschrieb. Mit GPT-3 verdeutlichte OpenAI 2020 das Potenzial dieser Modelle auch außerhalb der Forschung. Bekannte Beispiele wie GPT-4 (OpenAI, 2023), DALL·E 2 (OpenAI, 2022) oder BERT (Google AI, 2018) zählen zu dieser Modellklasse.

Wie funktionieren Foundation Models?

Foundation Models nutzen große Mengen an Trainingsdaten, um statistische Regelmäßigkeiten zu erkennen. Sprachmodellen sagen etwa vorher, welches Wort mit hoher Wahrscheinlichkeit auf ein anderes folgt. Bildmodelle dagegen analysieren und rekonstruieren visuelle Muster.

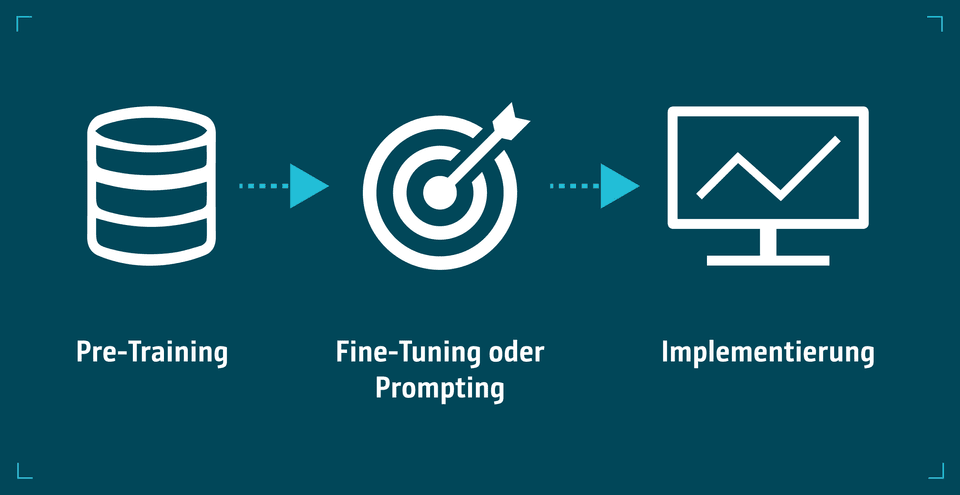

Typischerweise läuft die Entwicklung in drei Phasen ab:

- Pre-Training: Das Modell wird auf breitem, allgemeinem Datenmaterial trainiert, um grundlegende Zusammenhänge zu lernen. Dabei kommt häufig sogenanntes Self-supervised Learning zum Einsatz, ein Verfahren, bei dem das Modell aus den Daten selbst lernt, ohne dass diese manuell gelabelt werden müssen.

- Fine-Tuning oder Prompting: Das bereits trainierte Modell wird für spezifische Aufgaben angepasst oder gesteuert, z. B. durch Beispielaufforderungen (Prompts) oder ergänzende Fachdaten.

- Implementierung: Das Modell ist bereit, neue Daten als Eingabe zu empfangen und Vorhersagen über diese Daten auf der Grundlage von Mustern zu generieren, die im Pretraining und im Fine-Tuning gelernt wurden.

Anwendung bei INFORM

INFORM setzt Foundation Models ein, um KI-gestützte Prognosen nahtlos in seine Softwarelösungen zu integrieren und deren Leistungsfähigkeit deutlich zu steigern. Ein Beispiel dafür ist die Bedarfsplanung im Supply Chain Management. Im Gegensatz zu klassischen Zeitreihenverfahren, die auf starren Formeln basieren und jede Zahlenreihe isoliert modellieren, nutzt INFORM ein globales Foundation Model, das auf Millionen realer Absatzzeitreihen trainiert wurde. Dieses Modell erkennt typische Nachfragemuster aus unterschiedlichen Datenquellen und kann sie kontextabhängig auf neue Produkte übertragen. Dadurch lassen sich auch kontextabhängige Faktoren wie Produkttyp, Sättigungseffekte oder Marketingaktionen gezielt einbeziehen. Das Ergebnis sind deutlich differenziertere und robustere Prognosen, selbst für Artikel, für die nur wenige historischen Daten vorliegen, oder für neu auftretende Nachfrageverläufe.

Vorteile von Foundation Models

- Vielseitige Einsetzbarkeit: Foundation Models lassen sich für eine Vielzahl von Aufgaben anpassen, etwa für Textgenerierung, Bilderkennung, Übersetzung oder Analyse. Ein einmal trainiertes Modell lässt sich mit minimalem Zusatzaufwand in unterschiedlichsten Szenarien eingesetzen.

- Effizientes Fine-Tuning: Anstatt für jede Aufgabe ein neues Modell zu entwickeln, reicht oft die Feinabstimmung eines bestehenden Basismodells. Das spart Zeit, Kosten und ermöglicht eine schnellere Umsetzung individueller Anwendungen.

- Skalierbarkeit: Aufgrund ihrer universellen Struktur können Foundation Models leicht auf neue Daten und Anwendungsfelder übertragen werden. Das erleichtert es Unternehmen, mit einem Modell verschiedene Prozesse zu automatisieren und weiterzuentwickeln.

- Hohe Qualität der Ergebnisse: Durch das Training auf sehr großen und vielfältigen Datensätzen erreichen Foundation Models eine bemerkenswerte Ausdrucksstärke und Genauigkeit, besonders in der Sprachverarbeitung oder bei multimodalen Aufgaben.

- Innovationstreiber: Foundation Models gelten als zentrale Grundlage für viele aktuelle Fortschritte in der KI. Sie beschleunigen Forschung und Entwicklung, ermöglichen neue Produktideen und verändern die Art, wie KI in der Praxis genutzt wird.

Herausforderungen beim Einsatz von Foundation Models

- Hoher Infrastrukturbedarf: Die Entwicklung eines Foundation Models von Grund auf erfordert enorme Rechenressourcen und Investitionen. Das Training kann Wochen oder Monate in Anspruch nehmen.

- Hoher Energieverbrauch: Insbesondere große Modelle benötigen sehr viel Rechenleistung, was mit einem erheblichen Strombedarf verbunden ist. Die CO₂-Bilanz solcher Trainingsläufe ist daher ein wichtiger Nachhaltigkeitsfaktor, der bei der Entwicklung zunehmend in den Fokus rückt.

- Abhängigkeit von großen Datenmengen: Foundation Models benötigen eine breite und vielfältige Datenbasis, um leistungsfähig zu sein. Wenn der Zugang zu geeigneten Daten eingeschränkt ist, leidet die Qualität des Modells erheblich.

- Begrenztes Kontextverständnis: Trotz beeindruckender Ergebnisse fehlt den Modellen ein echtes Verständnis für die Intention oder den sozialen Kontext von Eingaben. Sie verfügen weder über Weltwissen im menschlichen Sinne noch über psychologisches oder situatives Einfühlungsvermögen.

- Fehlende Verlässlichkeit: Die generierten Antworten können unpräzise, irreführend oder sogar problematisch sein, etwa wenn sie unangemessene, toxische oder schlicht falsche Inhalte enthalten.

- Risiko von Verzerrungen: Da Foundation Models aus riesigen Datenmengen lernen, besteht die Gefahr, dass sie vorhandene gesellschaftliche Vorurteile, stereotype Darstellungen oder diskriminierende Sprache unreflektiert übernehmen. Um dem entgegenzuwirken, ist eine sorgfältige Auswahl und Aufbereitung der Trainingsdaten essenziell, ebenso wie eine ethisch fundierte Gestaltung der Modellarchitektur.

FAQ zu Foundation Models

Was ist der Unterschied zwischen Foundation Models und LLMs?

Foundation Models und Large Language Models (LLMs), sind eng miteinander verwandt, aber nicht gleichzusetzen. LLMs sind speziell auf die Verarbeitung und Erzeugung von Texten ausgerichtet. Foundation Models hingegen bilden einen übergeordneten Begriff: Sie umfassen nicht nur Sprachmodelle, sondern auch Modelle, die mit anderen Datentypen wie Bildern, Sprache oder Videos arbeiten können. Beide Modellarten teilen zentrale Eigenschaften, sie können semantische Beziehungen zwischen Wörtern erkennen, Texte übersetzen oder kontextbezogene Antworten generieren. LLMs gelten dabei als eine spezialisierte Unterkategorie von Foundation Models, die sich ausschließlich auf den Textbereich konzentriert.

Wie groß sind Foundation Models?

Foundation Models zählen zu den größten KI-Modellen überhaupt. Sie bestehen oft aus Hunderten Milliarden Parametern, was sie äußerst leistungsfähig, aber auch rechenintensiv macht. Für bestimmte Anwendungsfälle gewinnen jedoch kleinere Varianten an Bedeutung, die gezielt trainiert oder aus größeren Modellen abgeleitet wurden. Diese kompakten Modelle lassen sich effizienter betreiben und leichter in bestehende Systeme integrieren.

Wie erkennt man, ob ein Foundation Model für den eigenen Use Case geeignet ist?

Ob ein Foundation Model geeignet ist, hängt vom Einsatzziel ab: Geht es um Textverständnis, um die Verarbeitung von Bildern oder um die Kombination mehrerer Datenarten? Wichtig ist auch, ob allgemeine Fähigkeiten genügen oder ob domänenspezifisches Wissen notwendig ist. Ein guter Einstieg ist die Erprobung über bestehende Pilotprojekte, um zu testen, wie zuverlässig das Modell für die jeweilige Aufgabe arbeitet. Tools zur Evaluierung oder Anbieter wie INFORM helfen dabei, die passende Lösung zu identifizieren.

Fazit

Foundation Models verändern die Art, wie KI entwickelt und eingesetzt wird. Statt isolierter Einzellösungen bilden sie die technologische Basis für vielseitige, skalierbare und lernfähige Anwendungen. Entscheidend für ihren Erfolg ist jedoch die sinnvolle Integration in bestehende Prozesse sowie eine verantwortungsvolle, nachvollziehbare Nutzung. So tragen Foundation Models dazu bei, intelligente Systeme zu schaffen, die Fachanwender spürbar entlasten und Unternehmen nachhaltige Wettbewerbsvorteile bieten.

Möchten Sie erfahren, wie Foundation Models in Ihrer Branche Mehrwert schaffen können? Dann sprechen Sie mit unseren KI-Experten oder entdecken Sie weitere Anwendungsbeispiele in unserem Blog.

ÜBER UNSERE EXPERT:INNEN

Sina Schäfer

Corporate Communications Managerin

Sina Schäfer arbeitet seit 2021 als Corporate Communications Managerin im Corporate Marketing bei INFORM. Ihr Fokus liegt auf der externen Kommunikation zu den Themen Inventory & Supply Chain, Produktion und Industrielogistik.